16 Janvier 2025

L’IA au service de la détection des malwares

Articles

Aujourd’hui plus que jamais, la cybersécurité est devenue un enjeu stratégique pour les entreprises, la menace des malwares ne cesse de croître et d’évoluer : des ransomwares qui paralysent les infrastructures, des stealers qui dérobent des données confidentielles, ou encore des logiciels espions subtils qui infiltrent les systèmes.

Pendant des décennies, la détection par signatures a constitué une méthode efficace et largement utilisée pour identifier ces menaces. Mais aujourd’hui, cette approche montre ses limites face à des logiciels malveillants toujours plus sophistiqués.

Dans cet article, nous allons explorer comment l’intelligence artificielle, avec ses algorithmes avancés et sa capacité à analyser des contextes complexes, révolutionne la lutte contre les malwares en apportant des solutions à la hauteur des défis actuels.

La détection par signatures révolue

A la fin des années 80, les premiers antivirus utilisaient une méthode de détection appelée « empreinte » ou « signature » numérique. Cette technique consiste à analyser chaque fichier à l’aide d’un algorithme (dit algorithme de hachage) qui calcule un résultat unique, appelé empreinte numérique. En comparant cette empreinte numérique avec une base de données massive de menaces connues, l’antivirus peut alors savoir si le fichier est connu comme étant malveillant et ainsi le traiter.

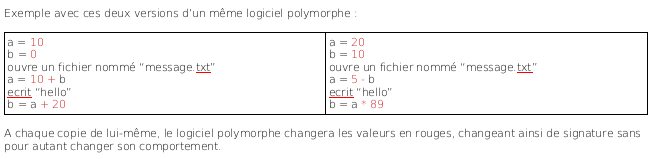

Pour contourner cette méthode de détection, les cybercriminels ont très vite développé des logiciels malveillants capables de changer leur empreinte numérique. Ces logiciels sont dits “polymorphes” pour les plus simples ou “métamorphes” pour les plus complexes.

En réponse, les experts en cybersécurité ont fait évoluer le mode de détection par signatures ; avec de nouveaux algorithmes de hachage, plus robustes aux changements dans le fichier (tel que SSDEEP – 2006), ou encore l’utilisation de signatures plus évoluées telles que les règles YARA (2007), qui permet la définition et le partage de signatures complexes et spécifiques (basées notamment sur les parties du fichier qui resteront inchangées quelque-soit les itérations du logiciel polymorphe).

Bien qu’encore massivement utilisées car très rapides, ces techniques restent limitées et fastidieuses. En effet, les nouvelles menaces restent invisibles jusqu’à leur analyse par un expert, et le nombre de faux positifs engendrés n’est souvent pas réellement maîtrisé.

Alors que faire ?

L’ajout de contexte

Les antivirus actuels, dits de nouvelle génération (NGaV), intègrent une analyse comportementale des fichiers pour détecter des actions malveillantes ; que ce soit sur le poste utilisateur (création/suppression de fichiers, accès à des ressources protégées…), ou au niveau réseau (communication avec un serveur de commande distant, exfiltration de données…).

La prise en compte de multiples facteurs, autrement dit du contexte, permet aux antivirus actuels d’être plus précis sur la détection. En effet, un document joint à un e-mail ne doit pas être traité avec la même attention en fonction de si l’expéditeur figure dans notre carnet d’adresse ou non ; ou encore, une application mobile ne doit pas être traitée avec la même attention si ses permissions requises ne sont pas en accord avec sa description.

Grâce à leur aptitude à traiter des contextes complexes, les algorithmes d’intelligence artificielle (IA) améliorent considérablement la précision des diagnostics, tout en gardant le nombre de faux positifs maîtrisé.

De plus, les modèles d’IA pouvant s’entraîner en permanence à partir de nouvelles données, il est possible d’automatiser le traitement de cette masse de données à entrées multiples (texte, images, code, actions…). Cette capacité d’adaptation leur permet ainsi de rester efficace face à l’évolution constante des stratégies des cybercriminels.

L’abstraction

Presque tous les pendants de l’intelligence artificielle sont aujourd’hui déployés dans le domaine de la cybersécurité : algorithmes de classification ou de clustering, apprentissage supervisé (reconnaissance de schémas caractéristiques), non-supervisé (détection d’anomalies), ou par renforcement (amélioration continue), etc.

Mais ces dernières années, ce sont surtout les avancées dans le domaine de l’apprentissage profond de réseaux de neurones complexes (deep learning) qui ouvrent les portes à de nouvelles capacités de détection.

En effet, ces algorithmes permettent de générer une représentation qui s’abstrait des détails et extrait les concepts clés de ce qui est donné en entrée (lire notre livre blanc à ce sujet). Il est par exemple possible de détecter des lettres de rançons dans des images, d’identifier si un site internet est un site de phishing, de détecter des vulnérabilités dans le code source, ou encore de détecter si un code est malveillant par nature (ex. PowerSheLLM, un outil de détection de code PowerShell malveillant développé par GLIMPS).

Cependant, bien que ces algorithmes d’IA aient des performances jusqu’ici inégalées, ils ont aussi leurs limites. Outre les ressources nécessaires pour les entraîner et/ou les mettre en œuvre qui peuvent parfois être importantes, la principale limitation serait dans l’acquisition et la gestion des données liées à l’entraînement de ces modèles d’IA.

En effet, d’une part, il faut constamment rester attentif à la présence de corrélations erronées dans les données d’entraînements que ces corrélations soient volontaires (dataset poisoning), ou involontaires (déséquilibre “naturel” lié aux sources des données par exemple).

Et d’autre part, de nombreuses questions se posent autour de la labellisation des échantillons (ce qui doit être classé ou non comme malveillant). Dans le cas de PowerSheLLM, la plupart des faux positifs sont des scripts légitimes d’administration mais avec des droits et des actions identiques à ceux utilisés dans le cadre de cyberattaques.

Les enjeux d’aujourd’hui

Pour GLIMPS, en plus des problématiques sur l’acquisition et la gestion des données d’entraînement, l’un des principaux enjeux actuels réside dans l’ajout d’explicabilité (XAI, eXplainable AI) aux sorties de nos modèles d’intelligence artificielle. En effet les modèles modernes, notamment ceux basés sur l’apprentissage profond, restent souvent perçus comme des « boîtes noires ». Cette opacité peut être problématique dans un contexte de cybersécurité, où il est crucial de comprendre pourquoi un fichier ou une action est identifié comme malveillant. Sans cette transparence, il devient difficile pour les experts de confiance de valider, interpréter, ou corriger les décisions de l’IA. Mais le sujet de l’explicabilité des modèles d’intelligence artificielle sera le sujet d’un prochain article.

En attendant, il faut garder à l’esprit que les cybercriminels utilisent des technologies similaires pour générer des malwares, concevoir des campagnes de phishing et monter des arnaques de plus en plus sophistiquées. Soyez donc vigilants sur les données que vous partagez en ligne, et adoptez de bonnes pratiques comme l’utilisation d’un gestionnaire de mots de passe, l’activation de l’authentification multifactorielle, et la vérification des sources avant de cliquer sur un lien ou de télécharger un fichier. Les cybermenaces de demain exploiteront tout le contexte disponible pour mieux cibler leurs victimes.